使用偽靜態(tài)屏蔽SEMRUSHBOT,AHREFSBOT,MJ12BOT等垃圾蜘蛛···

SemrushBot,AhrefsBot,MJ12bot,是什么爬蟲?能不能屏蔽。最近有一波SemrushBot,AhrefsBot,MJ12bot蜘蛛,天天訪問小白的小站。搜索了下原來又是一個國外的SEO分析爬蟲。如果你的站點面對的是國內(nèi)客戶,完全可以直接屏蔽。

互聯(lián)網(wǎng)上有一種說法,網(wǎng)上大約50%的流量都是爬蟲的貢獻,包括所說善意的爬蟲如各大搜索引擎,(其實有些搜索引擎光爬不怎么收錄也讓人煩),還有些惡性爬蟲不會帶來流量,還因為大量的抓取請求,造成主機的CPU和帶寬資源浪費,所以需要對其屏蔽。

下面來看看怎么樣屏蔽那些無用的垃圾蜘蛛爬蟲。

1:使用robots.txt屏蔽垃圾蜘蛛

將下面代碼復制到網(wǎng)站根目錄下的robot.txt文件里,這樣可以屏蔽掉以上的垃圾蜘蛛對于網(wǎng)站的抓取。

User-agent: AhrefsBot

Disallow: /

User-agent: DotBot

Disallow: /

User-agent: SemrushBot

Disallow: /

User-agent: Uptimebot

Disallow: /

User-agent: MJ12bot

Disallow: /

User-agent: MegaIndex.ru

Disallow: /

User-agent: ZoominfoBot

Disallow: /

User-agent: Mail.Ru

Disallow: /

User-agent: SeznamBot

Disallow: /

User-agent: BLEXBot

Disallow: /

User-agent: ExtLinksBot

Disallow: /

User-agent: aiHitBot

Disallow: /

User-agent: Researchscan

Disallow: /

User-agent: DnyzBot

Disallow: /

User-agent: spbot

Disallow: /

User-agent: YandexBot

Disallow: /

robots.txt(統(tǒng)一小寫)是一種存放于網(wǎng)站根目錄下的ASCII編碼的文本文件,它通常告訴網(wǎng)絡搜索引擎的蜘蛛,此網(wǎng)站中的哪些內(nèi)容是不應被搜索引擎的蜘蛛獲取的,哪些是可以被蜘蛛獲取的。因為一些系統(tǒng)中的URL是大小寫敏感的,所以robots.txt的文件名應統(tǒng)一為小寫。robots.txt應放置于網(wǎng)站的根目錄下。如果想單獨定義搜索引擎的蜘蛛訪問子目錄時的行為,那么可以將自定的設置合并到根目錄下的robots.txt,或者使用robots元數(shù)據(jù)(Metadata,又稱元數(shù)據(jù))。

robots協(xié)議并不是一個規(guī)范,而只是約定俗成的,所以并不能保證網(wǎng)站的隱私。

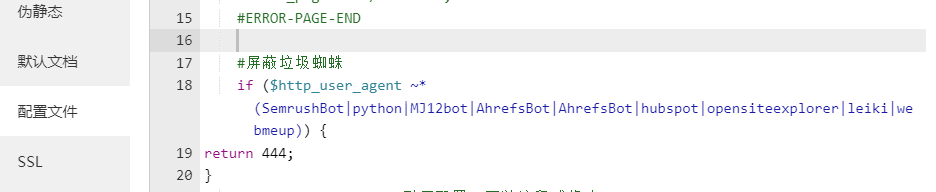

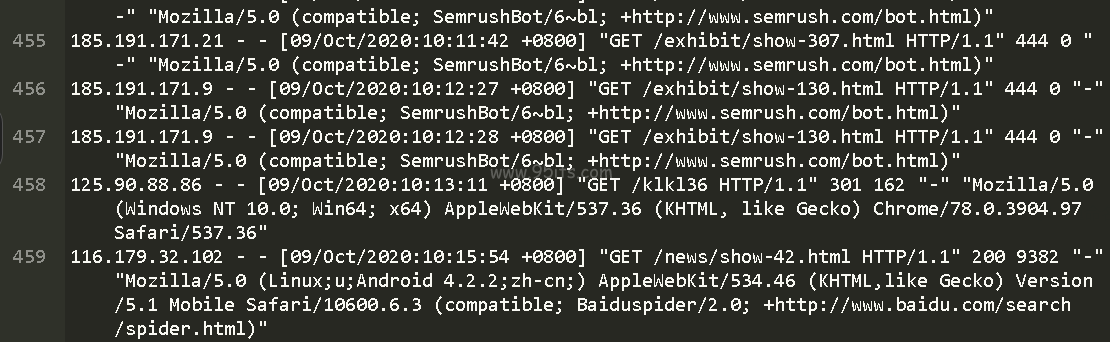

2:你是 linux nginx 服務器配置,可以在nginx配置文件里面加個客戶端判定。以BT寶塔為例, 寶塔面板可以在 網(wǎng)站配置里加上屏蔽 這些垃圾蜘蛛在來的時候 只能得到444 沒有任何數(shù)據(jù) 然后就不會再來了

if ($http_user_agent ~* (SemrushBot|python|MJ12bot|AhrefsBot|AhrefsBot|hubspot|opensiteexplorer|leiki|webmeup)) { return 444; } |

不影響正常蜘蛛抓取

這樣 谷歌蜘蛛,百度蜘蛛,搜狗蜘蛛,頭條蜘蛛都是 顯示正常抓取。正常發(fā)送數(shù)據(jù)

本站建議使用偽靜態(tài)的方式來屏蔽

偽靜態(tài)規(guī)則如下:

if ($http_user_agent ~* (SemrushBot|python|MJ12bot|AhrefsBot|AhrefsBot|hubspot|opensiteexplorer|leiki|webmeup)) {

return 444;

}

掃一掃,關注我們